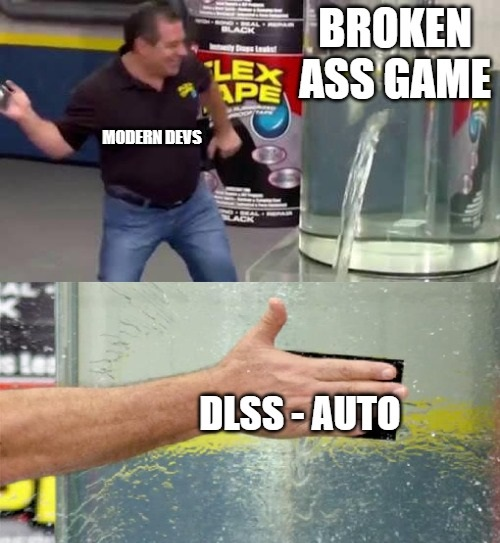

Osea que ni con la 5090 puedes jugar decentemente a los juegos en ultra sin pasar por el DLSS xD.

Es culpa de los que crean los juegos? De nvidia? O de ambos?

#595 esa gráfica me dice más del estado de la industria optimizando que la potencia de la gráfica xD

todavía no he visto un solo juego que luzca como rinde de todos los modernos que se arrastran

#602 si por software dices estudios tocándose los cojones sí.

ya se veía venir de todas formas xD

memes de hace años cuando sabíamos la que se venía y lo que iban a hacer los devs con esas tecnologías

#601 De los desarrolladores. Al final ellos son los responsables de como va a salir el producto, y en consola también va todo como la mierda, donde no esta Nvidia involucrada.

Y si los desarrolladores se salen con la suya es por culpa del consumidor. Nvidia puede prescindir de los gamers para vivir por tanto tampoco tenemos tanta capacidad de presión/voto, pero los devs no.

A seguir comprando ediciones delux con early access en un singleplayer por 90 o 100€ day1 mientras nos mean en la cara.

cuando creeis que bajaria el precio inflado de las ensambladoras dando por hecho que saldran caras de cojones? obvio no vemos el futuro pero en gens anteriores qué ocurrió?

#599 "Y si nada", esto son matemáticas, ciencia. 1+1.

No hay tu tía.

#601 A 4k, cuidado.

A 4k siempre ha sido jodidísimo correr los juegos, y lo seguirá siendo.

Metes 80% de resolución y a volar, manteniendo visuals de locos.

Y si no pues 1440p y a reventar.

O quitas RT vaya, que es una basura y en TODOS estos tests van a full con Path tracing.

#610 No puede estar la industria vendiendo el 4K (el último anuncio de la ps5 pro va por ahí). Y que sea 4K con mil mierdas a unos mierdosos 30fps.

Al menos en la epoca de la PSX, cuando un juego petardeaba veias, o te hacian creer, que estaban exprimiendo el hardware.

Si la industria quiere estandarizar el 4k@60 que lo haga sin dlss, que meter mil cosas, tropecientos efectos y cascarte una niebla que ni el pueblo de silent hill, era el recurso chapuzas de los 90.

#560 Menudo dolor de cabeza cuando lo veía montar los PC en el rack del sótabo y los cables hasta la zona de juego con periféricos y monitores.

En teoría brutal pero la práctica un dolor de huevos montar y configurar.

Es tan sencillo como no comprar juegos mal optimizados. Wu Kong? A tomar por el culo. Silent Hill 2? A la venta del nabo.

Y así uno tras otro.

#612 el que se siga tragando el juego en 4K o bien no tiene problemas económicos para poder cambiar de gráfica cada generación para poder jugar en dicha resolución o es que se deja llevar demasiado por el marketing. El grueso de los jugadores sigue haciéndolo en 1080/1440p y es por eso que se venden mas las gamas medias y bajas de cada generación que las gamas altas y medias-altas y como prueba un dedal: Cuáles son las gráficas mas usadas por los jugadores de Steam? La 3060, la 4060, la 4060 ti, la 3070, la 4070... Es por ello que la 5070 es la que ha tenido mas atención por parte de los medios, porque puede ser una gráfica ideal para jugar en 1440p con garantías sin tener que sacrificar nada o casi nada de calidad gráfica. Es mas, muchos están ya preguntándose si van a lanzar una 5060 o incluso una 5050.

Lo de las técnicas de rescalado? totalmente de acuerdo, pero creo que es mas por dejadez de las desarrolladoras que de los fabricantes de chips gráficos, llámese Nvidia, Intel o AMD. Los rescalados deberían ser una ayuda para las gamas bajas de gráficas y no como un requisito para poder jugar incluso en las gráficas de gama alta.

Mírate los KVM de Level1Tech (Wendell) que alguna vez han enseñado en LinusTechTips.

No son nada baratos pero parecen de muchísima calidad.

Baratos como dices sabes, por 750$ de nada: https://www.store.level1techs.com/products/p/combo-displayport-usb-c-kvm-with-usb-power-delivery

#612 Lo gracioso es que tragamos con la PSX infinita más mierda de lo que hay ahora.

la PSX era 240p, la mitad de NTSC que es 480i... pero no tiene una conversión exacta a los 576i de PAL, por lo que te comiste lineas negras en vez de ajustar la resolución.

La PSX iba a 30fps en NTSC y tenía que ir a 25fps en PAL... por lo que muchos juegos se convertían a base de reducirle la velocidad un 17%.

Y si encima tenías bajones le dabas gracias por "exprimir el HW" a pesar de que el juego probablemente estaba mal programado.

Todas las generaciones han sido igual, la PS360 nunca ha podido con 1080p, PS4one tampoco con 4k con una excepción, la one X, que daba gráficos de la one pero en vez de gastar más potencia en chorradas y efectos... iba todo prácticamente a resolución y fps... y ahí está el secreto.

En el momento que la gente deje de ser tan graphic whore y exigir mejores fps/resolución por encima de RT, verle el bigotillo a la prota y en general exigir eficiencia por encima de mejoras gráficas insignificantes... tendrán 4k@60... así que cuanto DLSS, frame gen, y demás mierda quieres?

TLDR: BO6 needs a game reset to apply settings. IGN may not have known this, benchmarked on settings that wasn't the "Extreme Preset" thus the data that they have.

Me parece más factible esto que las conclusiones que se podrían sacar usando el benchmark de ign y comparandolo con la 7900xt y 7900xtx

pues que quereis que os diga, yo cada vez veo mas gente quejarse del DLSS y de todo lo que vomiten con IA

#623 lo escuchas en un foro de freaks.

la gente normal lee, DLSS ON quality, (quality!, eso tiene que ser el setting mas alto de calidad, mola! mejor on que off) y lo digo porque lo he visto en streamers, que su trabajo es jugar, y ni saben eso.

y que miran el numerito de fps, y dicen wow, 250 fps (con frame gen) mejor que 145 fps (frame gen off)

si tio mira que suave todo! ahora va el doble de bien!

Según parece lo de Nvidia activa reescalado junto a frame gen para bajar la latencia.

Es decir, los frames generados no tienen por qué ser 100% fake sino que algunos son frames normales con su input y físicas sólo que renderizados a muy baja resolución y luego reescalados usando dlss y frames anteriores para calcularlos.

El problema que le veo a esta técnica es que bajará la latencia media, pero no tiene por qué bajar la real. Me explico:

F = frame nativo

f = frame a menor resolución

Renderizando 4k nativo:

F-------------F-------------F--------F-------------F

Renderizando 4k con generación

F--f------------F---f-------------F--f------------F-f

Ahí están sacando más fotogramas gracias a que cada frame intermedio está renderizado a, pongamos, 720p y reescalado a 4k con IA.

Si sacas la latencia media de ambos ejemplos de ve que el primero tiene más latencia, pero el segundo sólo reduce la latencia cuando está generando fotogramas a poca resolución, en el resto de casos es la misma. El problema es que luego te calculan la media y te hacen pensar que el juego responde mucho mejor al input.

Me gustaría ver un análisis detallado del tema porque esto es lo que creo que estará pasando, pero hacen falta pruebas reales.

#625 si no han cambiado nada, deberías poder elegir la calidad de renderizado como hasta ahora que FG es independiente de upscaling.

pero que para los benchmarks han usado dlss en modo rendimiento previo a fg dalo por seguro.

vamos, que están comparando 20fps nativos a 4k vs dlss a 720 reescalando a 4k + FG, pero eso ya lo llevan haciendo 2 años en sus gráficas de marketing

#626 es que en uno de los vídeos que vi ayer (no recuerdo cuál) salían unas gráficas en las que con fg no sólo aumentaban los fps sino que bajaban la latencia. Y eso sólo puede pasar si están renderizando frames reales y no sólo intermedios. Pero claro, si son con ultra reescalado lo de la latencia más baja es medio fake porque los no generados seguirán teniendo latencia alta si juegas a pocos FPS reales.